본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성하였습니다.

*_1. 학습 인증샷 4장 이상 포함

*_① 오늘자 날짜, 공부 시작 시각 포함 사진 1장

② 오늘자 날짜, 공부 종료 시각 포함 사진 1장

③ 1개 클립 수강 인증 사진 (강의장 목록 캡쳐, 강의 내용이 담긴 수강화면이 보이지 않도록) 1장

④ 학습 인증샷 1장 이상 (ex. 필기 촬영, 작업물, 등)

2. 학습 후기 700자 이상 (공백 제외)

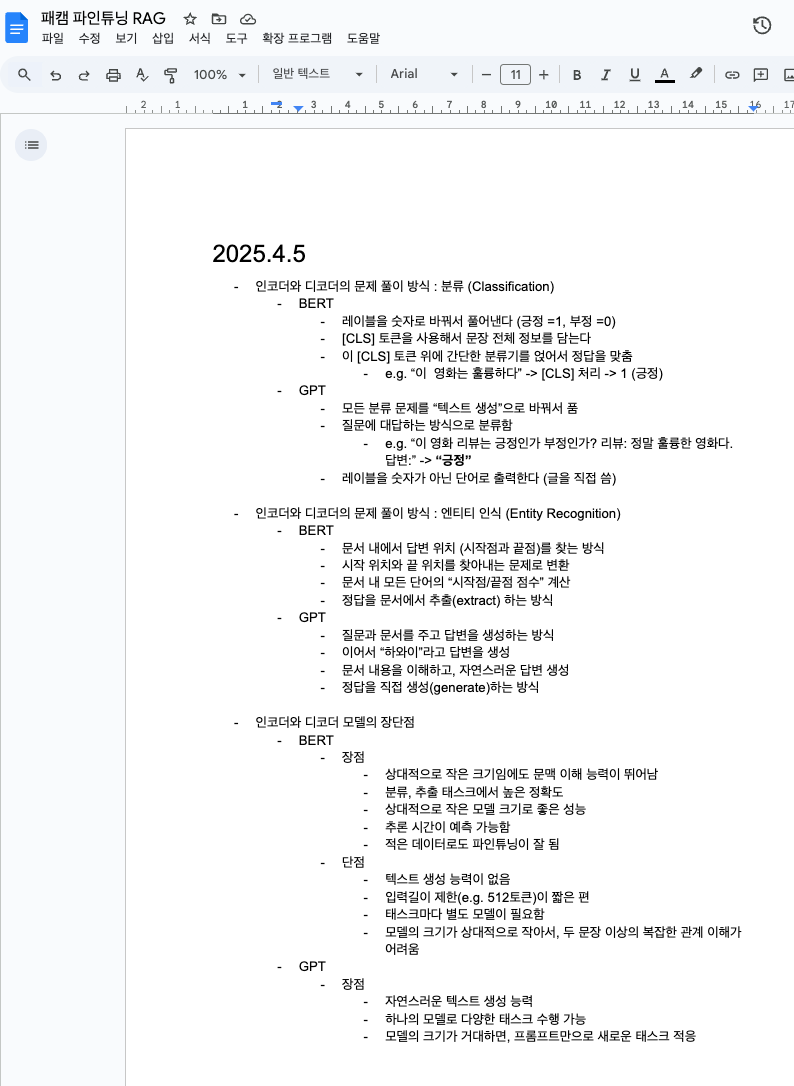

인코더와 디코더의 문제 풀이 방식 : 분류 (Classification)

- BERT

- 레이블을 숫자로 바꿔서 풀어낸다 (긍정 =1, 부정 =0)

- [CLS] 토큰을 사용해서 문장 전체 정보를 담는다

- 이 [CLS] 토큰 위에 간단한 분류기를 얹어서 정답을 맞춤

- e.g. “이 영화는 훌륭하다” -> [CLS] 처리 -> 1 (긍정)

- GPT

- 모든 분류 문제를 “텍스트 생성”으로 바꿔서 품

- 질문에 대답하는 방식으로 분류함

- e.g. “이 영화 리뷰는 긍정인가 부정인가? 리뷰: 정말 훌륭한 영화다. 답변:” -> “긍정”

- 레이블을 숫자가 아닌 단어로 출력한다 (글을 직접 씀)

인코더와 디코더의 문제 풀이 방식 : 엔티티 인식 (Entity Recognition)

- BERT

- 문서 내에서 답변 위치 (시작점과 끝점)를 찾는 방식

- 시작 위치와 끝 위치를 찾아내는 문제로 변환

- 문서 내 모든 단어의 “시작점/끝점 점수” 계산

- 정답을 문서에서 추출(extract) 하는 방식

- GPT

- 질문과 문서를 주고 답변을 생성하는 방식

- 이어서 “하와이”라고 답변을 생성

- 문서 내용을 이해하고, 자연스러운 답변 생성

- 정답을 직접 생성(generate)하는 방식

인코더와 디코더 모델의 장단점

- BERT

- 장점

- 상대적으로 작은 크기임에도 문맥 이해 능력이 뛰어남

- 분류, 추출 태스크에서 높은 정확도

- 상대적으로 작은 모델 크기로 좋은 성능

- 추론 시간이 예측 가능함

- 적은 데이터로도 파인튜닝이 잘 됨

- 단점

- 텍스트 생성 능력이 없음

- 입력길이 제한(e.g. 512토큰)이 짧은 편

- 태스크마다 별도 모델이 필요함

- 모델의 크기가 상대적으로 작아서, 두 문장 이상의 복잡한 관계 이해가 어려움

- 장점

- GPT

- 장점

- 자연스러운 텍스트 생성 능력

- 하나의 모델로 다양한 태스크 수행 가능

- 모델의 크기가 거대하면, 프롬프트만으로 새로운 태스크 적응

- 긴문맥수천 토큰)을 처리할 수 있음

- 창의적인 콘텐츠 생성이 가능함

- 단점

- 환각(hallucination) 문제

- 거대 언어 모델의 경우 필요한 리소스가 큼

- 생성 과정을 완전히 제어하기 어려움

- 장점

GPT의 발전

- GPT-1, 2, 3은 아키텍처 면에서 큰 차이가 없음

- 차이는 학습한 데이터의 양과 모델 크기

- ChatGPT (GPT-3.5, GPT-4)가 출시 된 후, 글로벌 대기업에서 자사의 트랜스포머 디코더 기반의 거대 언어 모델을 출시하고 있음

토크나이저

- 언어 모델은 내부적으로 텍스트를 특정 단위로 분할하여 처리함

- 특정 단위로 분할하여 처리하는 이 작업을 토큰화 (Tokenization)

- 분할된 단위를 토큰 (Token)이라고 함

- 동일한 텍스트의 입력에 대해서, 토큰이 나눠지는 결과는 거대 언어모델마다 전부 다 다름

토큰에 따른 과금

- 입력에 100만 토큰 사용하면 5달러

- 동일한 텍스트에 대해서도 LLM마다 토큰화 결과가 다름

- GPT-4o

- 토큰수 :154

- 토큰당 가격 : 0.0137원

- 전체비용 : 2.1원

- GPT-3.5-turbo

- 토큰수 :250

- 토큰당 가격 : 0.00137원

- 전체비용 : 0.34원

- 클로바X

- 토큰수 :250

- 토큰당 가격 : 0.005원

- 전체비용 : 0.54원

- GPT-4o

허깅페이스 (Huggingface)

- 거대 언어 모델들을 다운로드 할 수 있음

- 파인튜닝할 때 유용하게 사용됨

파라미터 수의 이해

- 딥러닝 언어모델의 파라미터 개수 (인간의 뇌세포에 비유)를 말할 때 ‘B’라는 표현을 자주 사용함 (10억개)

- GPT-3의 파라미터 개수는 1750억개 -> 175B

- LLama-3의 파라미터 개수는 1750억개 -> 70B

- 파라미터 수가 클수록 좀 더 좋은성능을 가지는 경향이 있지만, 그만큼 더 많은 GPU를 필요로 함

한글 LLM 리더보드

- 허깅페이스를 통해 제공되는 리더보드

- LLM에게 다양한 문제를 풀게하고 평균 점수가 높은 순서로 순위를 나열한 곳

- 리더보드에 나온 문제들에 특화되어, 내 서비스에는 적용이 안 될 가능성이 다분함. 점수가 높다해서 좋은 LLM이 아닐 수 있음

- 다양한 서비스에 적용되는지는 확인해봐야 함

url : https://abit.ly/lisbva

'스타트업 투자 > 데이터 + 테크' 카테고리의 다른 글

| 패스트캠퍼스 환급챌린지 7일차 : ChatGPT API를 이용한 데이터 생성 강의 후기 (0) | 2025.04.07 |

|---|---|

| 패스트캠퍼스 환급챌린지 6일차 : 프롬프트 엔지니어링 강의 후기 (0) | 2025.04.06 |

| 패스트캠퍼스 환급챌린지 4일차 : BART & T5 강의 후기 (0) | 2025.04.04 |

| 패스트캠퍼스 환급챌린지 3일차 : BERT & GPT 강의 후기 (0) | 2025.04.03 |

| 패스트캠퍼스 환급챌린지 2일차 : BERT 강의 후기 (0) | 2025.04.02 |

댓글